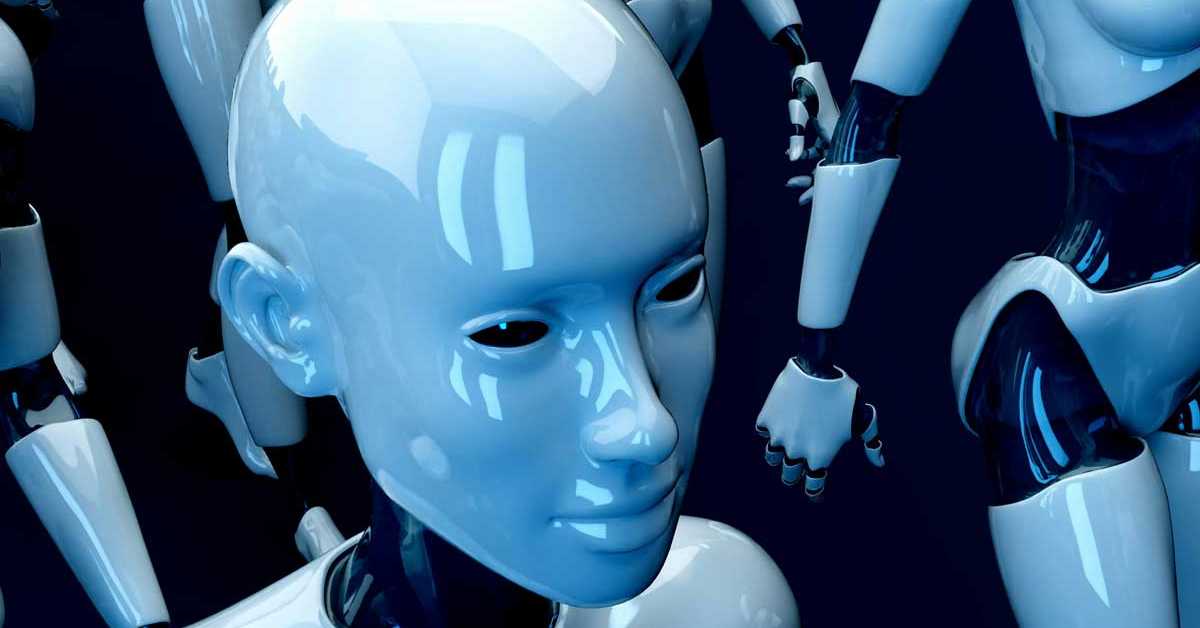

Људе ће заменити вештачка интелигенција и то је одлична вест

„Мета“, „Антропик“, „Алибаба“, „Мистрал“ и друге технолошке компаније већ неколико година представљају велике језичке моделе отвореног кода, али изгледа да је „Мета“ прва која има заиста добар разлог за то. Закербергова корпорација мења запослене вештачком интелигенцијом на веома специфичан начин. И, према оцени неких, то је одлична ствар.

Људе ће заменити вештачка интелигенција и то је одлична вест

Људе ће заменити вештачка интелигенција и то је одлична вест

Марк Закерберг је у последње време учинио доста да поправи свој имиџ у јавности. То може да буде резултат пажљивог планирања јер многи директори технолошких компанија имају лош имиџ. Заједно са новом сликом директора и компаније, „Мета“ је прихватила идеологију отвореног кода у области развоја језичких модела Лама (Llama AI).

Компанија која је синоним за вештачку интелигенцију захваљујући четботу ChatGPT, "OpenAI" (у преводу са енглеског језика Отворена вештачка интелигенција) почела је од отвореног кода, али се брзо брзо затворила да би се фокусирала на профит.

Док је неколико компанија следило њихов пример објављивањем својих модела, мало њих је променљиве моделе учинило доступним на начин на који је то учинила „Мета“.

У почетку су ове стратегије изгледале као решења која траже проблеме. Модели су могли да се користе при осмишљавању реклама, писању свих могућих текстова, за виртуелну стварност и много тога још.

Могућности су неограничене, али тренутне примене у стварном свету нису. Алат јесте занимљив, али једноставно не постоји прави пословни циљ осим да „буде најбоља вештачка интелигенција отвореног кода“.

Међутим, са изласком Ламе 3.2, „Мета“ се окренула ка једном веома важном циљу који директно утиче на њихов крајњи резултат и одрживи раст њихове платформе друштвених медија.

Кључ је у уређивању

Модерирање садржаја и неговање заједнице је жила куцавица друштвених медија. Без неке мере модерације или барем бирања корисног садржаја, долазимо до платформи које постају токсичне и деструктивне за заједнице за које је било планирано да подстакну њихов развој.

Неке платформе су због профита повећале толеранцију на агресивне реакције (као на пример Икс, то јест бивши Твитер) и то толико да је концепт уређивања потпуно изгубљен.

Тамо где сте некада могли да нађете друге људе сличних интересовања и њихове занимљиве садржаје, сада ћете наћи пустош који остаје иза вриштања и мржње. Све је дизајнирано тако да вас увреди, наљути, да вас натера да губите своје драгоцено време реагујући.

Фејсбук има проблем који никада нећете видети

Када означите нешто као садржај који задовољава ваше потребе или, пак, као штетан, човек мора да провери то што сте означили да би одлучио да ли се заиста крше нека правила. Ово делује као нормално и неопходно.

Неки би претпоставили да би многе такве пријаве могле бити претерана реакција корисника. Наравно, неко је објавио неки штетни политички садржај, али да ли је то заиста прекршило правила? Можда. Ту је провера корисна и од помоћи.

Међутим, најчешће не размишљамо о лошим намерама. Није реч о упорном троловању комшије у Фејсбук групи малог града, већ праве лоше намере – да се неко заиста повреди, мучи, злоставља итд.

Постоје стварни људи који објављују такав садржај и то на местима где би могао да изазове још већу штету. Када кликнете на „Пријави“, неки човек мора да погледа споран садржај и утврди да ли су правила прекршена.

И то је довољно шокантно. Али ако је прегледање таквог садржаја посао који неко ради осам до 10 сати дневно и изнова и изнова гледа потресне или ужасне слике и садржаје, то не може бити пријатно. Сваког дана, људска бића која покушавају да заштите заједницу бивају подвргнута таквој менталној тортури.

Решење се већ назире

Већ неко време „Мета“ ради на моделима заснованим на вештачкој интелигенцији који се могу применити у областима заштите. Један од резултата је LLama-Guard-3–1B. Ознака 1B указује на то да је модел трениран на једној милијарди параметара. Такви модели су веома мали у оквирима великих језичких модела, али оно што је добра вест је да „Мета“ активно прилагођава своје скупове података за ову функционалност.

Поређења ради, модел 1B вероватно може да ради на новијим телефонима. Нешто већи модели од 32B или већи (попут поједининих „Метиних“ модела од 405B) су вероватно кориснији за детаљан или нијансиран рад, који се обично изводи на већим серверима.

Отворени модел LLama-Guard-3–1B (слободан за преузимање) може да омогући малим компанијама да спроведу неку врсту контроле над својим заједницама и садржајем.

Модели намењени областима заштите, сматрају се мултимодалним, што укључује функционалности као што су категоризација и анализа слика или креирање сажетака текста.

Можете таквом алату дати слику, а он ће укратко „испричати“ шта слика приказује. „Мета“ тако заправо покушава да реши проблем својих запослених.

Ево посла који човек не мора да ради

Постоје послови које људи желе да раде, али и они које људи не желе да раде, али раде, постоје непријатни послови које људи раде које може да ради машина, а постоје послови које људи не би ни требало да раде. Такви послови константно наносе штету раднику.

Аутоматизација прераде нуклеарног отпада или изузетно токсичних материјала неће на ићи на отпор. Међутим, оно што многи не схватају је да посао пребирања по токсичном садржају није ништа другачији.

То су послови које људи не би требало да раде. Они су неопходни за безбедност и добробит свих, али на рачун појединца који свакодневно страда на свом радном месту. Зато су такви послови савршени за пребацивање на терен машинске интелигенције.

Иако је нопходна додатна регулација, као и веома пажљиво дефинисање података за тренирање модела, ово ће бити сјајна примена вештачке интелигенције.

Да, људе ће заменити вештачка интелигенција и то је, у овом случају, одлична вест.

Коментари